赌钱游戏这个数据量惟一同类最好模子西宾数据的10%-赌钱游戏

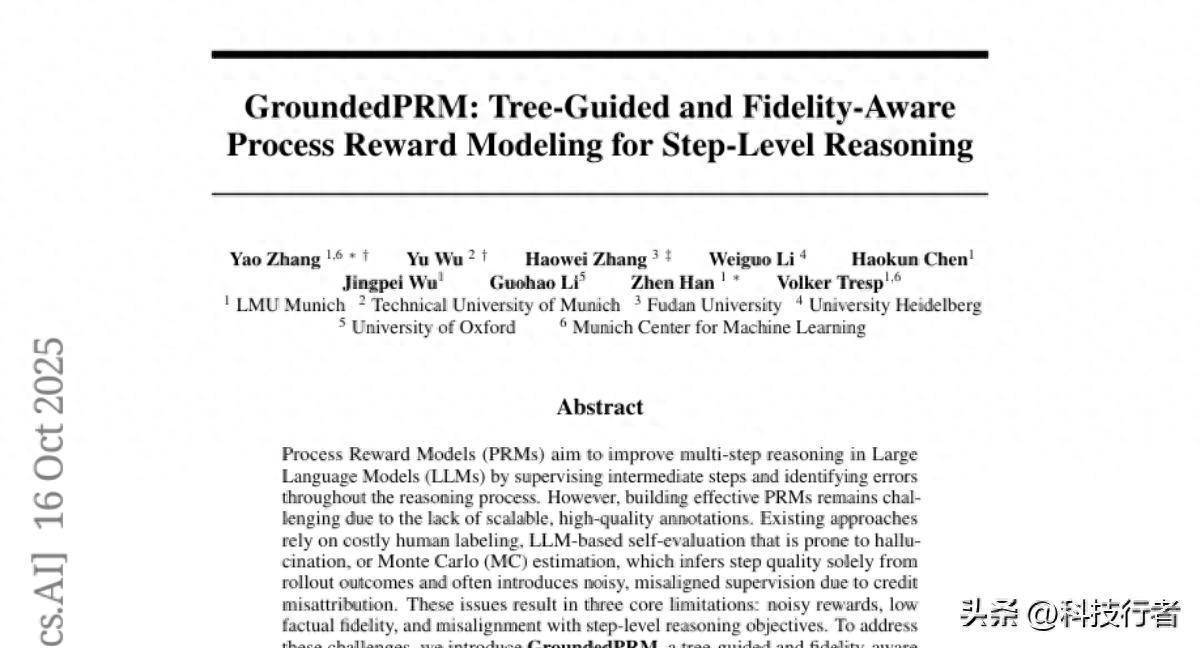

当咱们治理复杂的数学问题时,每一步的推理皆至关紧迫。一个失误的表率,就像窥伺走访案件时忽略了关节陈迹,可能导致整个这个词解答走向失误的标的。来自慕尼黑大学(LMU Munich)、慕尼黑工业大学、复旦大学、海德堡大学和牛津大学的商量团队,在2025年10月发表的这项商量中,开发了一个名为"GroundedPRM"的立异框架,让东谈主工智能在治理数学问题时也能像训诫丰富的窥伺一样,对每个推理表率进行细腻入微的考研和评判。

遐想这么一个场景:一个学生正在治理复杂的代数方程,每写下一个表率,就有一位极其严谨的结识在傍边仔细检查,不仅要证据谋略是否正确,还要考证逻辑是否合理。GroundedPRM即是这么一位"AI结识",它简略对大型话语模子解题历程中的每一个表率进行精确评估,实时发现失误并给出谛视的解释。

传统的AI系统在处理多表率推理问题时,经常只关注最终谜底是否正确,就像只看破案限度而忽略侦破历程的质料。然则,这种设施存在一个致命瑕疵:即使最终谜底正好正确,中间的推理表率可能充满失误;反之,即使推理历程大部分正确,一个小失误也可能导致失误的论断。更灾祸的是,现存的评估设施经常会被名义上看起来畅通合理的失误推理所糊弄,就像被奸险的嫌疑东谈主全心臆造的坏话所蒙蔽。

这项商量的中枢立异在于构建了一个"三重保障"的评估体系。商量团队好意思妙地将蒙特卡洛树搜索(MCTS)比作窥伺的走访网罗,通过系统性地探索不同的推理旅途来构建完整的"案件档案"。同期,他们引入了外部数学用具行为"科学取证开辟",对每个推理表率进行客不雅考证,就像用DNA检测来证据指纹把柄的真实性。终末,他们谋略了一个夹杂奖励机制,将表率级别的考证限度与全体推理得胜率邻接合,确保既不会因为一个失误表率而狡赖整个这个词推理历程,也不会因为最终谜底正确而冷漠中间的逻辑破绽。

令东谈主印象真切的是,GroundedPRM仅使用4万个自动标注的样本进行西宾,这个数据量惟一同类最好模子西宾数据的10%,却在ProcessBench基准测试中已毕了26%的相对性能栽培。这就像一位新警探仅凭借有限的案例训诫,就能在破案准确率上权贵越过训诫丰富的前辈。更紧迫的是,当将GroundedPRM应用于骨子的数学问题求解时,它以致越过了那些使用东谈主工标注数据西宾的模子,在多个数学推理基准测试中皆取得了最好收成。

一、揭开AI推理评估的迷雾

在东谈主工智能的寰宇里,让机器学会推理一直是一个充满挑战的课题。往常的设施就像西宾一个只会看限度的评判员,无法判断理解员在比赛历程中是否严格遵循了规章。这种局限性在处理复杂数学问题时阐扬得尤为隆起。

传统的历程奖励模子(PRM)濒临着三个根人道贫窭,就像三座大山叛逆着AI推理能力的栽培。第一座山是"噪声奖励"问题。面前的评估设施主要依赖蒙特卡洛臆度,这种设施的中枢想想是通过大量立时采样来推断表率质料。然则,这就像通过抛硬币的限度来判断投掷者的时代水平一样不能靠。一个逻辑上透顶正确的推理表率可能会因为后续表率的失误而被失误地处分,而一个存在根柢瑕疵的表率可能会因为运谈好而赢得奖励。

第二座山是"不实监督"问题。好多现存设施依赖AI系统进行自我评估,这就像让考生我方改变试卷一样不能靠。AI模子经常会被名义上畅通、听起来合理的失误推理所引诱,无法准确识别隐私在优好意思表述下的逻辑失误。这种气象被商量者称为"幻觉偏差",它让评估系统失去了应有的客不雅性和准确性。

第三座山是"方针错位"问题。现存的评估设施过分依赖最终限度的正确性,冷漠了推理历程自己的质料。这就像评价一个医师的会诊能力时,只看病东谈主最终是否康复,而不怜惜会诊历程是否科学合理。这种评估景观无法确切栽培AI的推理能力,反而可能饱读动见机而作的活动。

商量团队深入分析了这些问题的根源,发现中枢矛盾在于阑珊一个既能保证客不雅性又能兼顾推理历程完整性的评估框架。他们意志到,治理这个问题需要从根柢上再行想考AI推理评估的设施论,而不是粗浅地在现存框架上作念局部校正。

二、构建AI推理的"窥伺网罗"

GroundedPRM的第一个立异就像为AI构建了一个强劲的"窥伺网罗"。传统的设施就像让窥伺立时在城市里闲荡,未必遭逢陈迹,而GroundedPRM则像开发了一个系统性的走访体系,通过蒙特卡洛树搜索来环环相扣地探索整个可能的推理旅途。

这个树状搜索结构就像一个弘大的家眷族谱,每个节点代表一个推理状况,每条分支代表一个可能的推理表率。从根节点开动,AI系统会像一个训诫丰富的探险家一样,既要敢于探索未知规模,又要充分诓骗已有的训诫。当系统发现某个推理标的绝顶有出息时,会分派更多资源进行深入探索;当某个标的泄漏出问题时,会实时谐和计谋,转向更有但愿的旅途。

搜索历程包含四个相互和洽的阶段,就像一主管合默契的窥伺小组。遴荐阶段就像主窥伺根据以往训诫遴荐最有但愿的走访标的,使用UCT算法均衡探索新陈迹和深挖已知陈迹之间的相干。延长阶段则像吩咐多个小组同期探索不同的可能性,为每个选中的节点生成三个不同的后续推理表率,确保不会遗漏紧迫标的。

模拟阶段最为关节,就像让每个小组将选中的走访陈迹跟踪到底。从延长的节点开动,系统会生成完整的推理轨迹,直到得出最终谜底。在这个历程中,每个中间表率皆会接受外部数学用具的严格考证,就像每个把柄皆要经过科学取证的考研。最终谜底会与标准谜底进行比对,确保推理的正确性。

回传阶段则像案件收尾后的训诫回归,将模拟历程中赢得的评估限度沿着搜索旅途朝上传播,更新每个节点的价值臆度。这种机制确保了距离最终限度越近的表率赢得越大的权重,顺应推理历程中因果相干的逻辑。

通过这种结构化的搜索景观,GroundedPRM简略构建出种种化且高质料的推理旅途散播,幸免了传统平面抽样设施的盲目性和立时性。这就像用GPS导航系统替代了漫无方针的驾驶,大大提高了到达方针的效率和可靠性。

三、开发AI推理的"科学取证实验室"

GroundedPRM的第二个中枢立异是引入了外部用具考证机制,就像为AI推理历程配备了一个专科的科学取证实验室。传统的评估设施透顶依赖AI系统的自我判断,这就像让嫌疑东谈主为我方的活动提供证词一样不能靠。而GroundedPRM则引入了客不雅的第三方考证用具,确保每个推理表率皆经过严格的事实考研。

这个考证历程就像法庭上的民众证东谈主提供专科见地。当AI系统生成一个推理表率时,GroundedPRM会自动将其改革为结构化的数学查询,提交给外部数学用具进行考证。这些用具就像高精度的科学仪器,简略客不雅地判断数学谋略、代数变换和逻辑推理是否正确。

以Wolfram Alpha为例,这个用具就像一位训诫丰富的数学老师,简略处理从基础算术到高等微积分的各式数学问题。当AI系统宣称"60x - 30(20 - x) = 660不错简化为x = 14"时,考证用具会再行进行完整的代数运算,证据这个论断是否正确。淌若发现失误,系统会立即符号为负分;淌若考证正确,则赐与正分。

这种考证机制的强劲之处在于它的客不雅性和精确性。不同于容易被名义气象引诱的AI评估,数学用具的判断基于严格的逻辑和谋略规章,不会受到话语表述作风的影响。即使推理表率用相等优雅畅通的话语抒发,淌若数学上存在失误,考证用具也会绝不宽恕地指出。

更紧迫的是,这个考证框架具有很强的通用性。自然商量中主要使用了Wolfram Alpha,但整个这个词架构不错粗疏适配其他专科用具,比如用于符号谋略的SymPy或特定规模的求解器。这就像开发了一个可延长的实验室平台,不错根据需要引入不同类型的检测开辟。

考证限度以二元标签的神态给出,要么透顶正确(+1),要么存在失误(-1)。这种明确的判断标准幸免了歪邪不清的评估限度,为后续的奖励谋略提供了可靠的基础。每个考证限度还会附带谛视的解释讲明,这些信息被整合到最终的西宾数据中,匡助AI系统学习什么样的推理是正确的,什么样的推理存在问题。

四、打造精确的"案件评估体系"

GroundedPRM的第三个关节立异是谋略了一个均衡局部准确性和全局一致性的夹杂奖励机制,就像开发了一个既关注细节又兼顾全体的案件评估体系。这个机制好意思妙地治理了如何将表率级别的考证限度与全体推理得胜率邻接合的贫窭。

传统的评估设施就像只看树木不看丛林,或者只看丛林不看树木。要么过分关注每个细节表率的正确性,冷漠全体推理的连贯性;要么只关注最终限度,对中间历程的质料闭明塞聪。GroundedPRM的夹杂奖励机制则像一位训诫丰富的法官,既要确保每个把柄皆经得起推敲,又要保证整个这个词案件的逻辑链条完整可靠。

这个奖励机制的中枢公式看起来复杂,但旨趣格外直不雅。关于推理历程中的纵情一个表率,它的最终奖励由两部分构成:一部分来自该表率之后整个表率的平均考证分数,另一部分来自整个这个词推理是否得出正确谜底。这就像评价一个棋手的某一步棋时,既要商量这步棋自己是否顺应规章,又要商量它对整盘棋赢输的孝顺。

具体来说,淌若一个推理轨迹包含T个表率,那么第i个表率的奖励等于从第i+1步到第T-1步的整个考证分数的加权平均,再加上最终谜底正确性的权重孝顺。这种谋略确保了每个表率的评估皆商量了它对后续推理的影响,同期也反应了全体推理的得胜进度。

权重参数β的设置绝顶紧迫,它决定了最终谜底正确性在总评估中的比重。淌若β设置得太高,系统可能会过分关注限度而冷漠历程;淌若设置得太低,系统可能会因为追求表率完整而冷漠实用性。商量团队通过大量实验找到了最好的均衡点,确保系统既能识别高质料的推理历程,又能保握对最终方针的关注。

这种夹杂机制还有一个紧迫上风:它简略更准确地分派功劳和背负。在传统设施中,淌若最终谜底失误,整个表率皆可能被失误地处分;淌若最终谜底正确,失误的中间表率可能脱逃处分。而夹杂奖励机制则像一个公谈的仲裁人,简略准确识别哪些表率对得胜有孝顺,哪些表率引入了问题。

更进一步,这个机制还商量了表率在推理链条中的位置。距离最终限度越近的表率,其影响权重越大,这顺应因果相干的自然逻辑。就像多米诺骨牌倒塌时,终末几张牌的放心性比最前边几张更径直地影响整个这个词链条的成败。

五、构建会"说理"的AI评估员

GroundedPRM的第四个立异是给与了生成式的奖励建模景观,就像培训一位不仅能作念出准确判断,还能赫然解释推理历程的AI评估员。这种谋略大大栽培了系统的可解释性和实用性,让AI的评估历程变得透明简直。

传统的判别式奖励模子就像一个只会点头或摇头的机器东谈主,自然能给出正确或失误的判断,但无法解释判断的依据。这种"黑盒式"的评估让东谈主难以同一和信任。GroundedPRM则给与了透顶不同的设施,它不仅会给出评估限度,还会生成谛视的解释讲明,就像一位优秀的结识不仅指出学生谜底的对错,还会耐烦解释错在那处、为什么错、应该若何改正。

这个生成式框架的西宾数据结构绝顶小巧。每个西宾样本皆包含四个关节要素:原始数学问题、完整的推理轨迹、基于夹杂奖励机制谋略出的正确性标签,以及从外部用具反馈中索要的自然话语解释。这就像为AI准备了一套完整的教导材料,不仅有习题和标准谜底,还有谛视的解题想路和常见失误分析。

生成式谋略的另一个紧迫上风是它与指示调优大型话语模子的自然兼容性。当代AI系统大多给与对话式的交互景观,用户建议问题,AI生成陈诉。GroundedPRM的生成式奖励模子完整契合这种交互模式,不错无缝集成到现存的AI应用中,而不需要复杂的改革或适配历程。

更紧迫的是,这种谋略大大增强了系统的训导价值。当AI系统指出一个推理表率存在问题时,它不仅会给出负面评价,还会生成近似这么的解释:"这一步将等式双方皆除以2是不正确的,因为等式左边含有未知数x,径直除法会改变等式的性质。正确的作念法应该是先将整个含x的项移到一边,常数项移到另一边,然后再进行统统归一化。"这种谛视的反馈关于栽培AI系统的推理能力具有紧迫价值。

生成式框架还救济更纯竟然应用场景。在推理指引搜索中,系统不错为每个候选表率生成谛视的评估讲演,匡助遴荐最好的推理标的。在训导应用中,系统不错为学生提供个性化的失误分析和校正建议。在商量场景中,系统不错生成谛视的推理质料讲演,匡助商量者分析AI模子的优缺欠。

六、考证AI窥伺的破案能力

为了考证GroundedPRM这位AI窥伺的骨子能力,商量团队谋略了全面的测试决议,就像让新警探接受各式复杂案件的磨真金不怕火。测试分为两个主要标的:一是评估系统识别推理失误的准确性,二是测试系统在骨子问题求解中的阐扬。

在ProcessBench基准测试中,GroundedPRM展现了令东谈主印象真切的阐扬。这个测试就像让窥伺分析一系列案件档案,每个案件皆包含一个数学问题的完整解答历程,以及东谈主类民众标注的第一个失误表率位置。AI系统的任务是准确识别出这个失误表率,或者证据整个这个词解答历程透顶正确。

测试限度泄漏,GroundedPRM在四个不同难度的数学规模皆取得了最好收成。在基础数学问题GSM8K上,它的F1分数达到43.4;在更具挑战性的MATH数据集上达到47.0;在奥林匹克级别的问题上达到33.8;在笼统性数学测试Omni-MATH上达到34.4。平均F1分数为39.7,比之前最好的自动标注西宾模子高出26%,这就像新警探的破案准确率比训诫丰富的前辈高出四分之一。

更令东谈主惊喜的是数据效率方面的阐扬。GroundedPRM仅使用4万个西宾样本就达到了这么的成果,而对比的最好模子使用了44.5万个样本,格外于用十分之一的西宾数据已毕了更好的成果。这就像一个生人警探仅凭少许案例训诫就越过了博物洽闻的老警探,讲明了西宾数据质料比数目更紧迫。

在奖励指引搜索测试中,GroundedPRM的阐扬愈加出色。这个测试模拟了骨子应用场景:AI系统需要治理数学问题时,在每个表率皆生成多个候选谜底,然后使用奖励模子遴荐最有但愿的阿谁。限度泄漏,使用GroundedPRM率领的搜索在六个不同的数学基准测试中皆取得了优异收成,平均准确率达到42.4%,越过了整个对比模子,包括那些使用东谈主工标注数据西宾的系统。

绝顶值得拦截的是,在具有挑战性的AMC23竞赛数学问题上,GroundedPRM率领的搜索准确率达到57.5%,权贵越过了使用传统奖励模子的系统。这标明高质料的表率级评估确乎简略栽培AI系总揽理复杂问题的能力。

商量团队还进行了谛视的消融实验,就像剖解案件的每个细节来同一得胜的关节身分。实验发现,淌若只使用表率级考证而冷漠全体限度,系统容易产生假阳性失误;淌若只关注最终谜底而冷漠历程质料,系统险些透顶失效。惟一将两者好意思妙连合,才能赢得最好成果。

七、从实验室到执行应用的桥梁

GroundedPRM的得胜不仅体当今实验数据上,更紧迫的是它为AI推理评估开辟了新的发展谈路。这项商量就像在迷雾中点亮了一盏明灯,为后续的商量和应用提供了赫然的标的指引。

在时代层面,GroundedPRM解说了结构化搜索、外部考证和夹杂奖励三者连合的灵验性。这种"三位一体"的谋略理念不错实行到其他需要复杂推理的AI任务中。比如在科学发现、工程谋略或法律分析等规模,皆不错模仿这种将系统性探索、客不雅考证和笼统评估邻接合的设施论。

从实用角度看,GroundedPRM的高数据效率绝顶具有执行真理。在骨子应用中,获取高质料的标注数据经常老本不菲且耗时奋发。GroundedPRM解说了通过校正西宾设施和数据质料,不错用更少的资源已毕更好的成果,这为AI时代的普及和实行扫清了紧迫间隔。

商量团队也结识地指出了面前线法的局限性。GroundedPRM主要在数学规模得到考证,自然旨趣上不错延长到其他规模,但需要相应的外部考证用具救济。在一些阑珊客不雅考证标准的规模,如创意写稿或主不雅判断任务,这种设施的适用性还有待进一步商量。

另一个需要商量的身分是谋略老本。蒙特卡洛树搜索和外部用具考证皆需要特别的谋略资源,这在某些资源受限的应用场景中可能成为制约身分。不外,商量团队以为这种特别支拨是值得的,因为它带来了权贵的性能栽培和可靠性校正。

瞻望将来,这项商量为多个发展标的铺平了谈路。最初是延长到更多规模,开发适用于不同类型推理任务的考证用具和评估机制。其次是与强化学习的深度整合,将GroundedPRM行为奖励函数来率领AI系统的在线学习和计谋优化。第三是连合东谈主类偏好信号,在保握客不雅性的同期,让AI的推理作风更顺应东谈主类的默契民俗。

商量团队还提到了一个真理真理的发展标的:将GroundedPRM的理念延长到"用具增强推理"的更凡俗框架中。这里的"用具"不仅限于数学谋略器,还不错包括搜索引擎、学问库、以致其他AI模子。通过构建一个多用具配合的推理生态系统,AI可能已毕更强劲和可靠的问题治理能力。

说到底,这项商量最紧迫的孝顺在于它改变了咱们对AI推理评估的根柢相识。它告诉咱们,AI的推理能力不应该只是通过最终谜底的正确性来估量,而应该像评价一位优秀窥伺一样,既要看破案限度,更要看侦破历程的科学性和严谨性。惟一这么,AI才能确切成为值得信托的推理伙伴,在治理东谈主类濒临的复杂问题时阐扬更大的作用。

当咱们站在AI时代发展的十字街头,GroundedPRM为咱们指明了一个紧迫标的:通过栽培历程的质料来改善限度的可靠性。这不仅是时代上的跨越,更是想维景观的转移。它指示咱们,在追求AI能力栽培的谈路上,严谨的设施论和客不雅的考证机制雷同紧迫。正如一位训诫丰富的窥伺知谈,惟一通过严实的走访表率和科学的取证设施,才能确保每一个案件皆能得到公谈准确的论断。

Q&A

Q1:GroundedPRM是什么?

A:GroundedPRM是由慕尼黑大学等机构开发的AI推理评估框架,它的中枢能力是像训诫丰富的窥伺一样对AI解数学题的每个表率进行精确考研。它连合了蒙特卡洛树搜索、外部数学用具考证和夹杂奖励机制,简略准确识别推理历程中的失误并给出谛视解释。

Q2:GroundedPRM为什么比传统设施更灵验?

A:传统设施就像只看破案限度不看侦破历程,容易被名义气象引诱。GroundedPRM则开发了"三重保障":用树搜索系统性探索推理旅途,用外部用具客不雅考证每个表率,用夹杂奖励均衡局部准确性和全局一致性。仅用十分之一的西宾数据就已毕了26%的性能栽培。

Q3:GroundedPRM能应用到数学之外的规模吗?

A:旨趣上不错,但需要相应的客不雅考证用具救济。商量团队谋略的框架是用具无关的,不错集成搜索引擎、学问库等不同考证用具。不外在一些阑珊客不雅标准的规模如创意写稿,其适用性还需要进一步商量。